요즘 AI 기술의 발전은 눈부십니다. 최근 CrewAI라는 곳에서, 여러가지 역할 분담을 부여받은 AI Agents들을 활용하는 것을 보고 크게 감명을 받았는데, Together.ai에서 발표한 블로그 글을 보고 또 큰 감동을 받았습니다.

Together.ai가 소개한 "Mixture of Agents (MoA)"는 여러 대형 언어 모델(LLM)의 장점을 하나로 결합하여 인공지능 성능을 한 단계 더 끌어올리는 혁신적인 접근법입니다. MoA는 다양한 LLM들이 협력하여 보다 정교하고 높은 품질의 응답을 생성하는 구조를 채택하고 있습니다. 이번 리뷰에서는 MoA의 주요 특징과 그 성과에 대해 살펴보겠습니다.

MoA의 혁신적인 구조

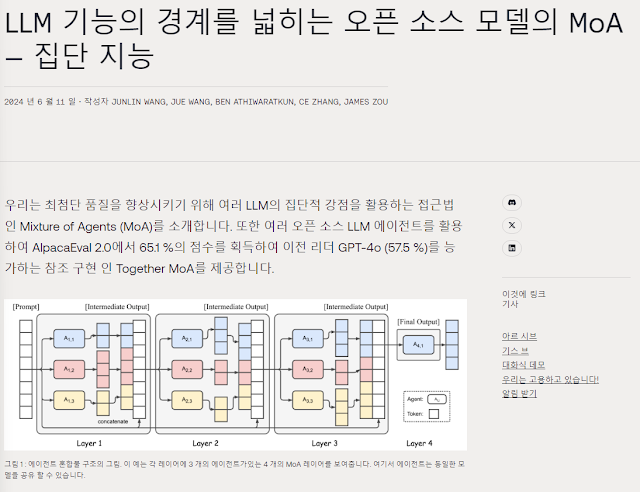

MoA의 핵심은 여러 LLM이 층(layer) 구조로 구성되어 있다는 점입니다. 각 층에는 여러 LLM 에이전트가 포함되어 있으며, 이전 층의 출력 결과를 바탕으로 보다 정교한 응답을 생성합니다. 이는 각 모델의 다양한 능력과 통찰을 통합하여 더욱 강력하고 다재다능한 모델을 만들어냅니다.

특히, Together MoA는 공개된 오픈 소스 모델만을 사용하여 AlpacaEval 2.0에서 65.1%의 점수를 기록했습니다. 이는 이전 리더였던 GPT-4o의 57.5%를 크게 뛰어넘는 성과입니다. 물론, 이러한 높은 정확성은 첫 번째 토큰 생성 시간이 다소 길어지는 단점이 있지만, 이 부분은 향후 연구에서 개선될 예정이라고 합니다.

협력의 힘을 보여주는 Mixture of Agents

MoA는 LLM들이 서로의 출력을 참고할 때 더 나은 응답을 생성하는 현상을 기반으로 합니다. 이를 입증하기 위해 다양한 오픈 소스 모델을 평가한 결과, 각 모델은 다른 모델의 출력을 참고했을 때 기본 점수보다 크게 향상되는 모습을 보였습니다.

MoA는 각 모델의 역할을 'Proposers'와 'Aggregators'로 나눕니다. Proposers는 초기 참고 응답을 생성하며, Aggregators는 이러한 응답을 종합하여 하나의 높은 품질의 응답을 만듭니다. 이러한 계층적 프로세스를 통해 최종적으로 더욱 견고하고 포괄적인 응답을 도출해 냅니다.

Together MoA의 성과

Together MoA는 6개의 오픈 소스 모델을 Proposers로, Qwen1.5-110B-Chat을 최종 Aggregator로 사용하여 3층 구조를 채택했습니다. 이러한 구성을 통해 AlpacaEval 2.0, MT-Bench, FLASK와 같은 표준 벤치마크에서 탁월한 성과를 기록했습니다. 특히, AlpacaEval 2.0에서 GPT-4o 대비 7.6%의 절대적인 향상을 이루어냈습니다. 또한, MoA-Lite 구성은 비용 효율성이 높으면서도 GPT-4o와 유사한 성과를 보여주었습니다.

비용 대비 효과

Together MoA는 높은 성능을 자랑하지만, 이는 다소 높은 비용이 수반됩니다. 하지만 MoA-Lite 구성은 성능과 비용 사이의 균형을 잘 맞추어 더 경제적인 대안을 제공합니다. 이는 다양한 사용 시나리오에서 MoA의 실용성을 높이는 요소로 작용할 것입니다.

결론 및 향후 방향

Together MoA는 여러 오픈 소스 LLM의 협력을 통해 강력한 성능을 발휘하며, 기존의 폐쇄형 모델을 뛰어넘는 성과를 보여줍니다. 이러한 접근법은 오프라인 처리, 훈련용 합성 데이터 생성, 높은 정확도가 요구되는 애플리케이션 등 다양한 분야에서 즉각적인 적용이 가능합니다.

앞으로 MoA의 구조적 최적화, 지연 시간 개선, 다양한 모델 및 프롬프트의 조합 실험 등을 통해 더욱 향상된 성능을 기대할 수 있습니다. 특히, 복잡하고 정교한 문제 해결 능력을 강화하기 위한 연구가 지속될 것입니다.

Together.ai의 MoA는 AI 발전의 새로운 가능성을 보여주는 좋은 사례입니다. 앞으로의 연구와 발전이 기대되는 만큼, AI에 관심 있는 분들에게 이 기술을 주목할 만한 가치가 있습니다.

원본 출처 : https://www.together.ai/blog/together-moa

'뉴스' 카테고리의 다른 글

| 자주 사용하는 HTML CSS, Javascript 꿀팁 (0) | 2024.08.25 |

|---|---|

| AI 때문에 증가할 직업과 감소할 직업 (0) | 2024.08.25 |

| 애플, 앤트로픽, 엔비디아, 세일즈포스 등 주요 AI기업들이 약 17만개의 유튜브 영상 무단 사용 (0) | 2024.08.25 |

| Andrej Karpathy의 새로운 교육 플랫폼 개시 (0) | 2024.08.25 |

| DeepL의 차세대 언어 모델 - 번역 품질의 혁신 (0) | 2024.08.25 |